E.T.Shimizu

第一章 人工頭脳

−− ニューラルネット幻想

<脳内バックプロパゲーションはあるか?> −−

生命体の司令塔とも言える脳に対して,1945年より,電子技術世界からの挑戦がはじまりました.それは真空管式コンピューターENIACの出現です.

ニューラルネットワークとは?

ニューラルネットワークとは?

人間の脳は,奇妙な機械とも言えます.

19世紀末から,グラハム・ベルによる電話機の発明,エジソンの錫箔蓄音機や炭素フィラメントの白熱電球に続き,ガソリンエンジン自動車,ブラウン管,映画の原型となるシネマトグラフ等が次々と発明され,20世紀に入るとライト兄弟が初の動力飛行に成功するなど,機械文明がめざましい発展をとげました.

この時,人々は人間も一種の機械であり,その行動原理もいずれ機械の行動原理を拡張して説明できる日がくると考えたようです.そして1945年,ENIACという真空管式コンピューターが出現して以後,人々はこの種の機械に『人工頭脳』という名前を与えたのです.

しかし,コンピューターと人間の頭脳が,かなり違うということは,誰の目にも明らかでした.それはパターン認識のジャンルではっきり差があるわけです.つまりノイマン型と呼ばれる「ストアド・プログラム方式」の計算機では,例えばテレビカメラを使って数字一つ読んで解釈するにも,その手順書(プログラム)作りが困難で,それができても実行時間が非常にかかり,認識誤りも多いといった欠点があるわけです.

その点,人間の脳は手順を自己学習し,認識作業は一瞬で済み,誤りも少ないのです.

そこで,脳の神経細胞の情報処理方法に似せた素子構造,配線構造を計算機に取り入れれば,そのすぐれた機能を再現できるかもしれないと考えられるようになりました.

御承知のように神経細胞(ニューロン)は,樹状突起(デンドライト)を外部に張り巡らした特異な形状の細胞です.そこから出たアクソンが,隣のニューロンのシナプスに接続することにより,信号を別の細胞に伝達する構造を持っています.

ここで例えば「思考する」という作業を見てみますと,それは現在の状況と,過去の情報をもとにして,未来の行動を決定する作業であるといえます.

ということは,必要な入力は,「現在の状況」と保存されている「過去の情報」の2種であり,出力は,未来行動のための「起動信号」であると言えます.

これは具体的には複数のシナプスで受け取った入力を演算して,アクソンに出力する情報処理作業とも言えますので,これをまねた人工的な素子の結線で機能を実現することが検討されたわけです.

こうしてできた人工素子結線網は「ニューラル・ネットワーク(Neural Network)」と名付けられました.

これらの素子には,複数の入力端子,各入力の強度調整器,入力の演算器,出力端子があります.そして,それらが複数集まって,各素子の出力は次の素子の入力に接続され,全体でネットワークを構成するわけです.

時には,ある素子の出力が,数段前の素子の入力に接続されるという,いわゆる「フィードバック回路」を形成することもあり得ます.

このように,神経の動作を単純化して,人工素子に置き換えてしまうことで,その挙動解析を,いろいろな条件で実行してみることができるようになったわけです.

自己学習能力

自己学習能力

実神経細胞の主要機能は「識別能力」です.

さきほどの人工識別の例では,テレビカメラで数字を撮影するわけですが,例えば「3」が撮影されれば,その数字が画面の端にあっても,裏返しでも小さくても横向きでも,ちゃんと「3である」という出力を出してほしいですし,事実,人間はそういう識別を実行することができるわけです.

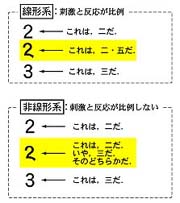

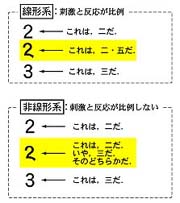

識別能力を獲得することは,数学的には「非線形化」を行うことに相当します.つまり書かれている数字を見て「2」か「3」かを識別するということは,手書き数字のように,大きさや位置がバラバラであっても,その線図形のカーブなどを追っていって,最終的に2つのカテゴリーのどちらかに情報縮退させることです.これは多値情報を,ある閾値で区切って大小を決定する非線形化処理です.

しかし,人間は生まれながらにして,すべての識別能力を備えているわけではなくて,後天的に学習しながら,これを獲得していくことが知られています.

ということは,人間における非線形化作業も,単に入力の演算値と,ある閾値との大小関係を調べるといった,単純な処理ではなく,入力の数だけの次元数を持った空間の中に「イエス領域」と「ノー領域」が複雑に境界を接し合っていて,その中のどこに結果を落とし込むか,というような非線形処理をしていると想像されます.

また自己学習が可能ということは,その領域境界面をどこに置くかという決定が,後天的に定められていくことを意味します.つまり学習という作業により,境界面が繰り返し修正されることで,手書き数字などバラバラな位置,大きさのもの正しくカテゴライズされるようになっていくと思われます.

この自己学習の仕組みの要素は,人工素子であるニューラル・ネットワークに当てはめると「入力強度調整器」にあります.

これは入力信号に,ある数字をかけ算する働きをします.つまり1を掛ければ入力は変化せずに演算器に達しますが,0.5 を掛ければ半減してしまいます.また(−1)を掛ければ,入力の効果は逆転して,興奮性入力が抑制性入力に変化します.これは入力に重み付けをしていることになります.

この重み付けの違う複数の入力の有無で演算結果が変わって,それが判断結果へ結びついていくわけです.

ここで,ある入力の組み合わせが望ましい結果を出さなかった時を考えましょう.つまりそのニューラル・ネットワークの判断が誤っていた場合は,さきほどの「入力強度調整器」の重み付けを変化させて正しい判断になるようにし向けていく必要があります.この再調整を行うことで,学習作業が成立していくのです.

そこで,ニューラル・ネットワークでは,結果が誤っていた時,具体的処置として,人間が(実際にはプログラムが)調整器の重み付けを変更して,正しい結果が出るように教育するわけです.

1986年,ラメルハート(D.E.Rumelhart)とヒントン(G.E.Hinton)によって,この教育アルゴリズムである「パックプロパゲーション」が開発されました.

それは,任意の入力に対して,最終出力を得るニューロンの入力の重み付けを動かしてみて,入力に対応する結果が正しい方向に動くように操作するわけです.

しかし,ニューロン接続が多段になっていると,終段出力への前段全体の変動も影響するため,その入力重み付けも勘定に入れ,さらにその前段の重みも,と再帰的に決定していく方法です.つまり本来の信号の流れとは逆方向に誤差の伝播を捉えていくので,バックプロパゲーションの名称があるのです.

この再帰収束演算作業で,やっと1回の学習が終わるわけです.

これに再び,別の入力を与え,こんどはその入力だけに興奮し,最初の入力には興奮しないような別出力を得られるよう,全段の各重み付けが決定できれば,少なくとも2種の入力を識別できる学習は完了となります.

しかし,現実には,異なった重み付け条件が,同じ出力結果になってしまうことはよくあります.結果の判断は最終出力が理想値に近いかどうかですから,たまたま近ければ,その重み付けが採用されてしまうわけですが,実際にさらに重み付けを大幅に変動させてみたら,もっと理想出力に近い組み合わせが新発見されるということもよくあります.

ということは,その前の重み付けが,誤差の盆地(ローカルミニマム)に陥っていて,誤差レベルのもっと低い谷には達していなかったということになります.

つまり「学習は完了したんだが,いまひとつ冴えた判断をしてくれない」というケースが出がちです.まあ人間でも判断に鋭い鈍いはありますから,一概に人工神経だけの問題とは言えませんが,このあたりが,バックプロパゲーションの欠点とも言えます.

脳内学習

脳内学習

以上は,人工神経であるニューラルネットワークを使った学習の方法でした.では,実際の脳神経はどうでしょうか? バックプロパゲーションはどう実現されているのでしょう.

まずアクソンの現有結果と,「教師」ともなる望ましい理想結果を,比較するという作業ができるでしょうか? その前に,理想結果というものがどこからか提示されるのでしょうか? その結果によって各段のシナプスへの入力強度が徐々に修正されていく構造があるのでしょうか? 結論としては,きっとあるのだと思われます.そうでなければ,自己学習は成立しません.

情報処理システムの類推から,現在考えられる範囲では「教師」となるべき比較対照用理想結果は「センサーフュージョン」から得られるものです.これは,複数のセンサーから得られた結果を総合して,個々のセンサーからの入力以上の情報を引きだそうとするものです.

例えば,右の目で見える「3」と,左の目で見える「3」の像を認識するニューロン網は,途中(少なくとも皮質内1次視覚野V1の眼優位性カラム)までは共通ではありません.もし,発育の過程で,これら2つのニューロン網がほぼ等しい結果を出さなかったら,それが「不快感物質」を誘発し,等しい結果を出せば「快感物質」を出すようなメカニズムがあると考えれば,説明がつきそうです.

つまり人間はこの快不快を「教師」にして,結合強度の変更や,新しいニューロンの採用を試行していくのではないかと思われます.

センサーフュージョンは,同種のセンサー間の話だけではありません.映像と音の関係,映像と触覚の関係,それらの時間的同時性の関係,空間的同一性の関係など,複数のセンサーチャネルを使って,入力情報が脳に伝達された時,正誤を判定する手がかりが得られるわけです.

情報論的には,これは「冗長性」によるエラーコレクションと呼ばれますが,生体においては,この冗長性だけが,唯一の「教師」と考えられます.

そして長年の学習により,人間はこれら情報のそれぞれの生起確率の偏りまでも学習して,文字通り個々のセンサー入力以上の情報を獲得し,しまいには,単一のセンサー入力だけから,多分入ってくるであろう未入来の他センサーの入力を推定するまでに,賢くなっていくと想像されます.

− 第一章 完 −

「第二章 記憶容量

−− メモリー幻想

<脳はいかにして巨大記憶を得てきたか?> −−」

語句説明

- 非線形

線形(一次)の項のみでなく,高次の項も含む数式.また,未知関数あるいはその微分の高次の項を含む微分方程式.さらに,そのような方程式で記述される現象.⇔線形 (大辞林 第二版より)本文へ戻る

- 冗長性

〔redundancy〕言語による伝達の際,ある情報が必要最小限よりも数多く表現されること.冗長性があれば雑音などで伝達を妨げられても情報伝達に成功することがある.余剰性.(大辞林 第二版より)本文へ戻る